Luận án Về mô hình nhận dạng tư thế võ dựa trên ảnh chiều sâu

Trang 1

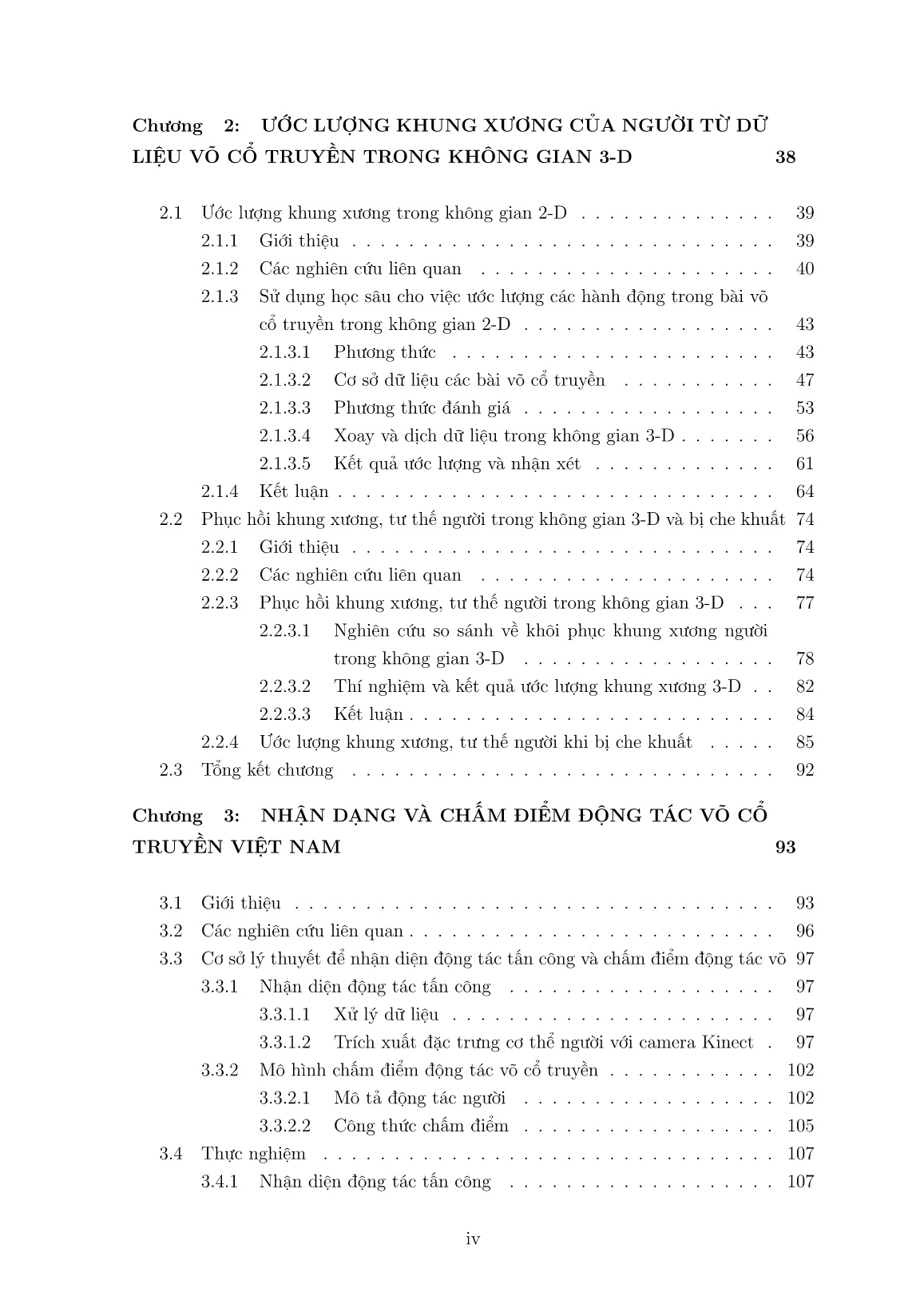

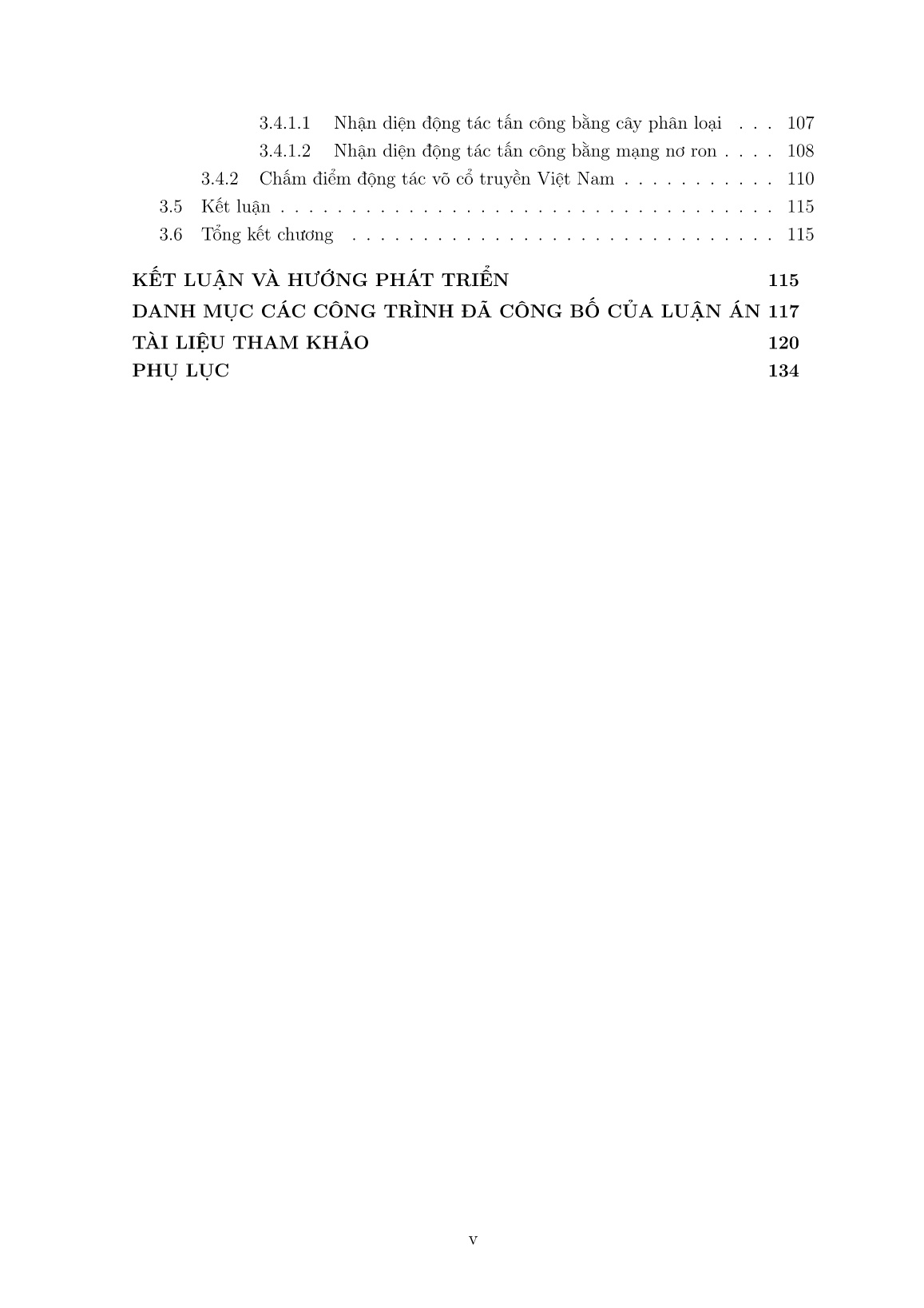

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Bạn đang xem 10 trang mẫu của tài liệu "Luận án Về mô hình nhận dạng tư thế võ dựa trên ảnh chiều sâu", để tải tài liệu gốc về máy hãy click vào nút Download ở trên.

Tóm tắt nội dung tài liệu: Luận án Về mô hình nhận dạng tư thế võ dựa trên ảnh chiều sâu

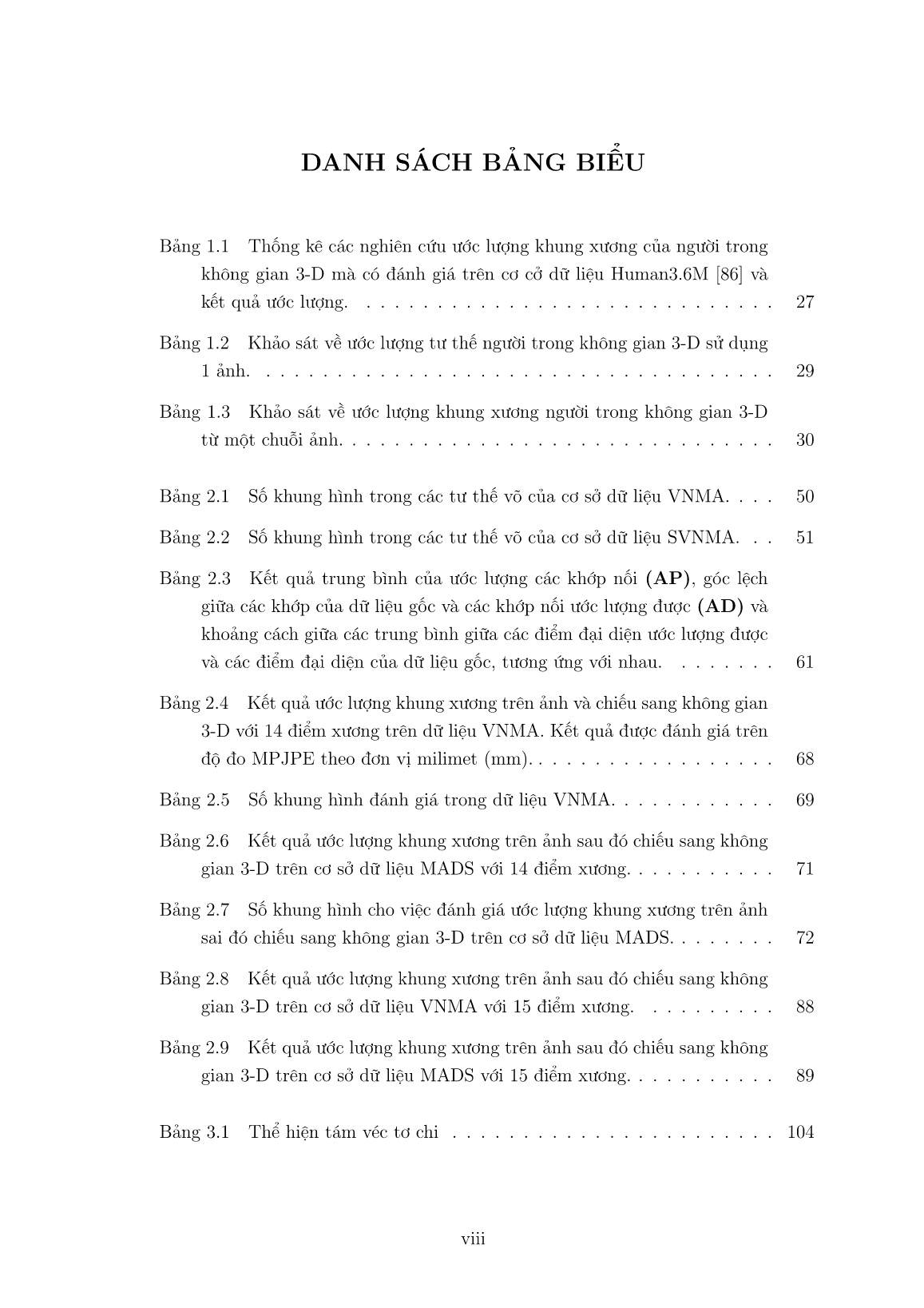

hư thể hiện trong Hình 2.8. Sự hợp nhất nhiều quy mô được lặp đi lặp lại được thực hiện bằng cách trao đổi thông tin qua các mạng con đa độ phân giải song song qua toàn bộ quá trình. Một vấn đề khác của HRNet là kiến trúc này không sử dụng giám sát bản đồ các vùng nổi bật trung gian, không giống như mô hình đồng hồ cát xếp chồng (Stacked Hourglass). Bản đồ các vùng nổi bật được hồi quy bằng cách sử dụng hàm sai số toàn phương trung bình MSE (Mean squared error). Toàn bộ quá trình cài đặc và thực hiện mạng HRnet được thể hiện trong đường dẫn sau: https://github.com/leoxiaobin/deep-high-resolution-net.pytorch. Tuy nhiên một vấn đề đặc biệt của mạng này là chạy song song tối thiểu trên 4 GPU nên yêu cầu về phần cứng của mạng này là rất lớn. Nên trong nghiên cứu này chúng tôi không chạy thực tế được hiệu năng của mạng này cho việc ước lượng khung xương, tư thế của người trên ảnh. Để trực quan hóa các kết quả ước lượng khung xương ở từng bước trong quá trình ước tính tư thế con người 3-D, chúng tôi đề xuất một nghiên cứu so sánh về ước lượng tư thế, khung xương người trong không gian 2-D (Nghiên cứu so sánh 2-D), nó được hiển thị trong Hình. 2.9. Trong Hình 2.9, luận án đánh giá theo hai phương thức: Phương thức đầu tiên (Phương thức 1 - Method 1) sử dụng mạng CNN CPM được huấn luyện trên trên cơ sở dữ liệu COCO [23]; Phương thức thứ hai (Phương thức 2 - Method 2) sử dụng mạng CNN CPM được huấn luyện trên trên cơ sở dữ liệu Human 3.6M [86]. Kết quả ước lượng khung xương, tư thế người trong không gian 2-D với tọa độ của từng 46 Hình 2.7 Minh họa kết quả ước lượng khung xương trên ảnh của mô hình đã được huấn luyện trên bộ cơ sở dữ liệu 2016 MSCOCO Keypoints Challenge [23]. điểm đại diện ước lượng được (xi, yi) trên hình ảnh màu, sau đó chúng được kết hợp với điểm ảnh có tọa độ (xi, yi) trên hình độ sâu theo phương trình (1.3) để tạo ra điểm đại diện (Xp, Yp, Zp) trong không gian 3-D. 2.1.3.2 Cơ sở dữ liệu các bài võ cổ truyền Võ cổ truyền là một môn thể thao rất quan trọng giúp con người rèn luyện sức khỏe và tự vệ. Ở rất nhiều quốc gia trên thế giới, đặc biệt là Châu Á có rất nhiều môn võ cổ truyền được lưu truyền từ đời này sang đời khác. Với sự phát triển của công nghệ thì việc lưu trữ và bảo tồn, cũng như dạy các thế võ này là rất quan trọng [15], [16]. Hiện nay cũng có rất nhiều loại cảm biến hình ảnh khác nhau có thể thu thập được thông tin về việc dạy và học võ của các võ đường. Trong đó cảm biến Kinect phiên bản 1 là lại cảm biến rẻ tiền nhất hiện nay. Đây là loại cảm biến có thể thu thập được nhiều thông tin như ảnh màu, ảnh độ sâu, khung xương, gia tốc trọng trường, âm thanh, vv. Để thu thập và đồng bộ dữ liệu từ cảm biến MS Kinect phiên bản 1, chúng tôi sử dụng công cụ thu thập dữ liệu đã được phát triển tại viện nghiên cứu quốc tế MICA, Đại học Bách khoa Hà Nội [19]. Bộ công cụ được phát triển dựa trên môi trường lập trình MS Visual Studio bản từ 2010 trở lại đây với sự hỗ trợ của bộ thư viện OpenCV và bộ 47 Hình 2.8 Minh họa kiến trúc mạng HRnet [115]. Trong đó chiều ngang và chiều dọc lần lượt thể hiện độ sâu và biến đổi kích thước cửa sổ của bản đồ đặc trưng. thư viện Nui của MS Kinect SDK 1.8 với ngôn ngữ lập trình C++. Bộ công cụ này sử dụng bộ tham số đã được công bố của Nicolas [31] để hiệu chỉnh ảnh màu và ảnh độ sâu về cùng một tâm. Đồng thời bộ tham số này cũng được sử dụng để chiếu các điểm ảnh của ảnh màu và ảnh độ sâu vào không gian 3-D. Từ các dữ liệu thu thập này có thể tái hiện lại môi trường trong không gian 3-D về việc dạy học võ tại các võ đường. Do trên cảm biến Kinect phiên bản 1 có gắn một số cảm biến như cảm biến ảnh màu, ảnh độ sâu, vv. Để thu được dữ liệu từ môi trường cảm biến sử dụng bộ công cụ MS Kinect SDK 1.8 để kết nối máy tính và cảm biến [17]. Công cụ thu thập dữ liệu, môi trường, thiết bị, hiệu chỉnh dữ liệu sử dụng trong nghiên cứu này như đã được trình bày trong phần ngữ cảnh. Môi trường, thiết bị được thể hiện trong Hình 5. Môi trường mà võ sư và các học viên biểu diễn võ thuật có kích thước là 3×3m. Thiết bị thu dữ liệu chỉ có một cảm biến MS Kinect được gắn trên giá và được đặt cố định. Bộ dữ liệu thu được bao gồm 24 cảnh và được gọi tên là "VNMA - VietNam Martial Arts" với 24 video tương ứng được dẫn link trong Phụ lục. Trong đó, được thu thập từ 24 người (12 người có giới tính là Nam, 12 người có giới tính là Nữ). 24 người này có độ tuổi từ 13 đến 20 tuổi (là học viên lớp võ cổ truyền). Luận án thu thập dữ liệu trên 24 người vì trong lớp võ mà nghiên cứu sinh kết nối xin hợp tác có 24 học viên. Trong đó, các học viên của lớp võ đã được truyền dạy các bài võ trong thời gian 1 tháng (tức là các học viên của lớp đã có kinh nghiệm cơ bản trong võ thuật). Trong lớp võ thì các học viên thường mặc quần áo màu xẫm, không bị bóng, chiều cao của các học viên là từ 1.4-1.7m. Cơ sở dữ liệu này được thu thập tại lớp dạy võ thuật cổ truyền tại Tỉnh Bình Định, Việt Nam. Bình Định là một một tỉnh mà được coi là miền đất võ nổi tiếng nhất của Việt Nam. Trong mỗi video, mỗi học viên biểu diễn một bài 48 Huấn luyện CPM trên cơ sở dữ liệu COCO (Method 1) Huấn luyện CPM trên cơ sở dữ liệu Human 3.6M (Method 2) Mô hình CNN cho ước lượng các điểm đại diện 2-D Kết quả ước lượng khung xương Ảnh đầu vào Khung xương 2-D Kết quả trong không gian 3-D Ảnh đầu vào (RGB) Ảnh độ sâu Chiếu kết quả 2-D sang không gian 3-D Nghiên cứu so sánh 2-D Hình 2.9 Nghiên cứu so sánh cho đánh giá ước lượng khung xương, tư thế trong không gian 2-D. võ, do đó mỗi khung hình trong video sẽ có một tư thế khác nhau. Cơ sở dữ liệu này chỉ bao gồm các ảnh có người trong ảnh. Trong bộ cơ sở dữ liệu này luận án cũng cung cấp dữ liệu gốc về khung xương, tư thế người trong không gian 3-D cho việc đánh giá ước lượng khung xương, tư thế người trong không gian 3-D. Dữ liệu gốc của các khớp xương được đánh dấu trên dữ liệu trong không gian 3-D. Để làm được việc này nghiên cứu hiển thị dữ liệu 3-D (dữ liệu đám mây điểm) của cảnh trên cửa sổ của một chương trình do nghiên cứu phát triển dựa trên môi trường lập trình Visual Studio và sự hỗ trợ của bộ thư viện PCL [35] với ngôn ngữ lập trình C++. Hình 2.10 minh họa việc làm dữ liệu gốc cho việc đánh giá ước lượng khung xương, tư thế người trong không gian 3-D. Trong đó nghiên cứu đánh dấu 17 đại diện (điểm xương) trên cơ thể người. Các điểm xương được đánh theo thứ tư như trong Hình 2.10. Trong đó, luận án không chọn điểm trên xương sống mà chỉ chọn điểm ở "Cổ" và "Giữa Hông" vì các điểm trên giữa xương sống gần như không thay đổi vị trí (xoay và dịch) ra khỏi hai điểm đầu của xương sống là "Cổ" và "Giữa Hông". Trong một số trường hợp khi dữ liệu bị che khuất nghiên cứu giả sử tay hoặc chân của người thường nằm sát với cơ thể người và được chọn như trong trường hợp dữ liệu của tay hoặc chân là nhìn thấy. Hiện tại việc đánh dấu các điểm trong không gian 3-D là được thực hiện bằng tay và chỉ trên dữ liệu của một phía của cảm biến MS Kinect. Còn lại khi dữ liệu bị che khuất mà hành động của người là phức tạp thì trong nghiên cứu này nghiên cứu chưa thực hiện được. Để đánh dấu được dữ liệu trong không gian 3-D khi bị che khuất người ta thường dùng hệ thống MOCAP [102] 49 cho việc tính toán tọa độ thực tế của tay và chân người trong các trường hợp này. (1) (2) (3) (4) (5) (6) (7) (8) (9) (11) (12) (13)(17) (16) (15) (10)(14) Cửa sổ chạy chương trình .exe Cửa sổ hiển thị trong không gian 3-D Hình 2.10 Minh họa việc đánh dấu dữ liệu gốc về khung xương, tư thế người trong không gian 3-D. Trong đó thứ tự đánh dấu của các điểm như sau: (1) Đầu, (2) Cổ, (3) Vai phải, (4) khuyủ tay phải, (5) cổ tay phải, (6) Vai trái, (7) khuyủ tay trái, (8) cổ tay trái, (9) Giữa hông, (10) Hông phải, (11) Đầu gối phải, (12) Cổ chân phải, (13) Ngón chân cái phải, (14) Hông trái, (15) Đầu gối trái, (16) Cổ chân trái, (17) Ngón chân cái trái Trong bộ cơ sở dữ liệu này nghiên cứu cũng cấp cấp dữ liệu đám mây điểm của từng cảnh tương ứng với từng khung hình thu được. Số khung hình ở mỗi video trong bộ cơ sở dữ liệu này được thể hiện trong Bảng 2.1. Toàn bộ cơ sở dữ liệu có thể tải về theo đường dẫn trong Phụ lục. Bảng 2.1 Số khung hình trong các tư thế võ của cơ sở dữ liệu VNMA. Video 1 2 3 4 5 6 7 8 9 10 11 12 Số khung hình 50 89 71 77 98 109 87 79 89 76 79 95 Video 13 14 15 16 17 18 19 20 21 22 23 24 Số khung hình 131 71 95 101 108 117 109 112 80 110 96 105 Ngoài ra, nghiên cứu cũng thu thập một tập dữ liệu nhỏ dựa trên cấu hình và thiết lập môi trường như trong bộ cơ sở dữ liệu VNMA. Tuy nhiên, trong tập dữ liệu này nghiên cứu thu thập chỉ trên một người có giới tính là Nam, 26 tuổi, quần màu nâu xẫm, áo màu xanh nước biển. Người này biểu diễn 14 thế võ khác nhau tương ứng với 14 đoạn video ngắn mà có số khung hình được thể hiện như trong Bảng 2.2. Tập cơ sở dữ liệu này được gọi là "SVNMA - Small VietNam Martial Arts". Trong đó, nghiên cứu thực hiện việc đánh nhãn (ground truth) các điểm đại diện của cơ thể người bằng 50 tay trong trên ảnh (không gian 2-D) như minh họa trong Hình 2.3 và Hình 2.11, với 18 điểm xương trên ảnh. Cơ sử dữ liệu này chỉ bao gồm các ảnh có người trong ảnh. Số khung hình trong bộ cơ sở dữ liệu này được thể hiện như trong Bảng 2.2. Hình 2.11 Các điểm đại diện (Key points) trên cơ thể người và nhãn. Bảng 2.2 Số khung hình trong các tư thế võ của cơ sở dữ liệu SVNMA. Video 1 2 3 4 5 6 7 8 9 10 11 12 13 14 #Khung hình 120 74 100 87 80 88 87 74 71 90 100 97 65 68 Cơ sở dữ liệu thứ hai mà luận án dùng đánh giá việc ước lượng khung xương, tư thế người là MADS- the Martial Arts, Dancing and Sports. [32]. Cơ sở dữ liệu này bao gồm các video thu thập ở nhiều hướng nhìn (multi-view RGB videos) và một hướng nhìn (depth videos). Nó bao gồm 5 kiểu hành động thách thức: Tai-chi, Karate, nhảy Hip-hop (Hip-hop dance), Khiêu vũ và thể thao (Jazz dance and sports). Tốc độ thu thập dữ liệu là trên các video là (10 khung hình/giây cho võ Tai-chi và Karate; 20 khung hình/giây cho khiêu vũ, nhảy hip-hop và các hành động trong thể thao). Độ phân giải của ảnh màu và ảnh độ sâu thu được là 1024 × 768 điểm ảnh. Tuy nhiên, trong cơ sở dữ liệu lưu trữ ảnh có độ phân giải là 512× 384 điểm ảnh. Dữ liệu gốc của bộ cơ sở dữ liệu này được chuẩn bị (đánh dấu) trong không gian 3-D thông qua việc sử dụng hệ thống MOCAP (MOtion CAPture) [33]. Hệ thống MOCAP sử dụng bảy cảm biến hình ảnh được đặt trên tường xung quanh không gian thu thập dữ liệu của không gian thu thập dữ liệu và các cảm biến xác định vị trí trên các khớp trên người biểu diễn võ thuật, khiêu vũ, hành động thể thao. Hệ thống MOCAP làm việc với tốc độ 60 khung hình/giây. Dữ liệu gốc (đánh dấu) về vị trí các điểm đại diện với 19 điểm theo thứ tự như sau: "cổ", "xương chậu", "hông trái", "đầu gối trái", "mắt cá chân trái", "ngón cái chân trái", "hông phải", "đầu gối phải", "mắt cá chân phải", "ngón chân cái phải", "vai trái", "khuỷu tay trái", "cổ tay trái", "tay trái", "vai phải", "khuỷu tay phải", "cổ tay phải", "tay phải", "đầu". 51 Trong nghiên cứu này, luận án chỉ đánh giá các video võ thuật cổ truyền theo một hướng nhìn trong bộ cơ sở dữ liệu này, chúng bao gồm các video võ Tai-chi và Karate. Các video này bao gồm 11200 khung hình. Trong đó, bộ tham số trong của cảm biến hình ảnh để hiệu chỉnh ảnh màu và ảnh độ sâu được thể hiện như sau: Hm = 331 0 254.097 0 331 180.032 0 0 1 (2.1) Hình 2.12 minh họa dữ liệu đám mây điểm của cảnh khi một người biểu diễn võ thuật Karate. −1000 −800 −600 −400 −200 0 200 400 600 800 −500 0 500 1000 1500 2000 −6000 −4000 −2000 0 x − axis y − axis z − a xi s Hình 2.12 Minh họa dữ liệu đám mây điểm của một cảnh. Các điểm màu xanh nước biển là dữ liệu của người trong môi trường 3-D. Cơ sở dữ liệu huấn luyện: Như đã trình bày ở trên, phương thức 1 là sử dụng mô hình ước lượng đã được huấn luyên trên cơ sở dữ liệu COCO [23]. Cơ sở dữ liệu này bao gồm hơn 200k ảnh và 250k người trên ảnh, trong đó dữ liệu đánh dấu của tập huấn luyện và xác nhận là từ 150k người với 1.7 triệu nhãn của các điểm đại diện. Mỗi người được đánh dấu bởi 17 điểm đại diện, được sắp xếp theo theo thứ tự như sau: Mũi, mắt trái, mắt phải, tai trái, tai phải vai trái, vai phải, khuỷu tay trái, khuỷu tay phải, cổ tay trái, cổ tay phải, hông trái, hông phải, đầu gối trái, đầu gối phải, mắt cá chân trái, mắt cá chân phải. Phương thức 2 là sử dụng mô hình ước lượng đã được huấn luyện trên cơ sở dữ liệu Human 3.6M [86]. Cơ sở dữ liệu này bao gồm 3.6 triệu ảnh, được thu thập từ 11 người (6 nam, 5 nữ) trong 17 ngữ cảnh khác nhau (thảo luận, hút thuốc, chụp ảnh, nói chuyện điện thoại, vv). Human 3.6M được thu thập và tính toán trên 15 cảm biến (4 máy quay video kỹ thuật số, 1 cảm biến thời gian, 10 camera theo vết). Cơ sở dữ liệu này cung cấp dữ liệu gốc khung xương cả 2-D và 3-D. Số khung hình của dữ liệu huấn luyện 52 và xác thực theo thứ tự là 35832/19312. Dữ liệu khung xương được đánh dấu với 17 điểm đại diện theo thứ tự như sau: "Xương chậu", "Hông phải", "Đầu gối phải", "Mắt cá chân phải", "Hông trái", "Đầu gối trái", "Mắt cá chân trái", "Cổ", "Đầu", "Giữa hông", "Vai trái", "Khuỷu tay trái", "Cổ tay trái", "Vai phải", "Khuỷu tay phải", "Cổ tay phải". 2.1.3.3 Phương thức đánh giá + Đánh giá trong không gian 2-D: Để thực hiện và đánh giá kết quả ước lượng bản đồ các điểm đại diện và các vector tương ứng của các bộ phận trên cơ thể người trong không gian 2-D (trên ảnh). Nghiên cứu thay đổi kích thước của ảnh đầu vào từ 640× 480 điểm ảnh sang 654× 368 điểm ảnh, để phù hợp với bộ nhớ trên GPU, như theo yêu cầu của mạng nơ ron tích chập. Quá trình đánh giá được thực hiện trên máy chủ có cấu hình đã trình bày ở trên. Quá trình chạy bao gồm hai phần chính: Thứ nhất là thời gian chạy của mạng nơ ron tích chập để ước lượng các bản đồ các điểm nổi bật và dự đoán vị trí các điểm, thứ hai là thời gian chạy dự đoán các khớp tương ứng trên nhiều người [24]. Hai phần này được đánh giá về độ phức tạp lần lượt là O(1) và O(N2), trong đó N là số người trong ảnh. Cũng giống như trong [24], nghiên cứu đánh giá độ tương tự của các điểm đại diện (object key point similarity (OKS)) và sử dụng độ chính xác trung bình (average precision (AP)) với ngưỡng OKS = 0.5. OKS được tính từ sự thay đổi kích thước của cơ thể người so với khoảng cách giữa các điểm đại diện ước lượng được và các điểm được đánh nhãn (ground truth). Việc tính toán tỷ lệ OKS được thực hiện trên từng khớp được tạo ra từ các điểm đại diện ước lượng được và được tính toán theo công thức trong [23], minh họa trong hình 2.13. Công thức trong hình 2.13 được chi tiết hóa như trong công thức (2.2). OKS = abs(| Gground −Rresult |) Gground (2.2) trong đó Gground là độ dài của véc tơ khớp xương gốc, Rresult là độ dài véc tơ khớp xương ước lượng được tương ứng theo chỉ số đã định nghĩa trước. Nếu OKS > 0.5, tức là sai khác lớn hơn 50% độ dài thì là một ước lượng sai ngược lại là một ước lượng đúng. Đồng thời luận án cũng thực hiện đánh giá góc lệch giữa khớp xương được gán nhãn (VG) và khớp xương ước lượng được (VE) từ các điểm đại diện được ước lượng (AD(%)). Trong đó, góc giữa 2 vec tơ (A= argcos(VG, VE)). Nếu (A ≤ 10o) là một ước lượng đúng, ngược lại là một ước lượng sai. Tỷ lệ (AD) được tính bằng số ước lượng đúng chia cho tổng số khớp. Ngoài ra nghiên cứu cũng tính khoảng cách trung bình của các điểm đại diện ước 53 Hình 2.13 Minh họa ma trận đánh giá độ tương tự độ dài của các khớp được tạo ra từ các điểm đại diện [28] lượng được với các điểm đại diện gốc đã được đánh dấu theo chỉ số đã được định nghĩa sẵn như trong công thức (2.3). D(pg, pe) = √ (xg − xe)2 + (yg − ye)2 (2.3) trong đó D là khoảng cách giữa hai điểm (pg, pe), pe là điểm đại diện ước lượng được mà có tọa độ là (xe, ye), pg là điểm đại diện được đánh dấu mà có tọa độ (xg, yg) trong không gian ảnh. Trong nghiên cứu này, luận án đánh giá độ đo (AD) vì trong thực tế có nhiều trường hợp khớp xương ước lượng có độ dài tương đồng với khớp xương gốc, nhưng nó bị lệch lên hoặc lệch xuống. Ví dụ: khớp xương khuỷa tay của dữ liệu gốc là thẳng sang ngang, nhưng khớp xương khuỷa tay ước lượng được là bị gấp lên trên. Hay khi khớp xương khuỷa tay gốc và khớp xương khuỷa tay ước lượng được là song song với nhau nên luận án cần đánh giá thêm độ đo (D) về khoảng cách giữa các điểm đại diện ước lượng được và dữ liệu gốc. Với dữ liệu đầu vào của hệ thống là ảnh màu, video. Dữ liệu đầu ra là kết quả ước lượng các điểm đại diện trên ảnh, đồng thời các khớp nối giữa các điểm đại diện cũng được thể hiện. Dữ liệu về nhãn và vị trí của các điểm đại diện ước lượng cũng được nghiên cứu lưu trữ ra file theo cấu trúc đã được định nghĩa trước như Hình 2.14. Trong nghiên cứu này, nghiên cứu đánh giá việc ước lượng khung xương, tư thế người theo các phương thức như trong Hình 2.15. 54 Hình 2.14 Minh họa thứ tự các điểm đại diện ước lượng được. Trong đó, các điểm màu xanh là các điểm quan tâm và đánh giá trong bài báo này. Hình bên phải thể hiện các khớp nối của các điểm đại diện quan tâm. Như vậy các độ đánh giá trên là sử dụng để đánh giá kết quả ước lượng trong không gian 2-D. Do đó, các độ đo này sử dụng để đánh giá kết quả ước lượng trên tập cơ sở dữ liệu SVNMA. Các kết quả được thể hiện trong Phần 2.1.3.5. + Đánh giá trong không gian 3-D: Việc đánh giá kết quả ước lượng trong không gian 3-D là rất quan trọng, vì trong môi trường này gần với môi trường thực. Để đánh giá kết quả ước lượng khung xương trong không gian 3-D, nghiên cứu sử dụng một độ do như sau: Cũng giống như trong nghiên cứu của Tome và các cộng sự [85], nghiên cứu sử dụng độ đo MPJPE (Mean Per Joint Position Error), độ đo này có nghĩa là trung bình lỗi về vị trí của các khớp, được tính như công thức (2.4). MPJPEk = ∑NP i=1 √ (xgi − xei)2 + (ygi − yei)2 + (zgi − zei)2 NP (2.4) trong đó, (xgi, ygi, zgi) là tọa độ của điểm xương của dữ liệu gốc (ground truth) trong không gian 3-D; (xei, yei, zei) là tọa độ của điểm xương thứ i th của dữ liệu ước lượng được (estimation) trong không gian 3-D; NP là số điểm xương thứ ith trên mỗi khung xương; k là chỉ số khớp xương người của khung hình thứ kth trong mỗi video. 55 Openpose_COCO được huấn luyện trên COCO dataset (Method 1) Openpose_Human 3.6M được huấn luyện trên Human 3.6M dataset (Method 2) Bộ ước lượng khung xương, tư thế người Kết quả ước lượng khung xương, tư thế người Ảnh đầu vào Stacked Hourglass Networks for Human Pose Estimation (Alejandro et al. ECCV 2016) Kết quả trên 2-D Kết quả chiếu sang 3-D Hình 2.15 Minh họa các phương thức cho việc đánh giá ước lượng khung xương, tư thế người trong không gian ảnh. Với độ đo này có thể sử dụng để đánh giá kết quả ước lượng khung xương trong không gian 3-D với hai cơ sở dữ liệu: VNMA, MADS. 2.1.3.4 Xoay và dịch dữ liệu trong không gian 3-D Trên thực tế thì kết quả ước lượng, khôi phục khung xương trong không gian 3-D được chiếu từ không gian 2-D sang hay được huấn luyện và lựa chọn mô hình khung xương tốt nhất phù hợp với dữ liệu 2-D thì kết quả ước lượng, khôi phục khung xương trong không gian 3-D có hệ trục tọa độ khác với dữ liệu gốc. Điều này xảy ra do khi ước lượng khung xương trên ảnh 2-D thì các mạng nơ ron tích chập thay đổi kích thước của ảnh đầu vào để phù hợp với dữ liệu đầu vào của mạng CNN đã được định nghĩa sẵn nên làm cho kết quả ước lượng thay đổi hệ trục tọa độ so với dữ liệu gốc. Hay do dữ liệu bộ thư viện khung xương gốc để huấn luyện ước lượng, khôi phục khung xương trong không gian 3-D với dữ liệu gốc của cơ sở dữ liệu kiểm tra là thuộc hai hệ trục tọa độ khác nhau. Nên để đánh giá được các kết quả ước lượng, khôi phục khung xương trong không gian 3-D thì kết quả ước lượng, khôi phục khung xương trong không gian 3-D và dữ liệu gốc cần được đồng bộ hóa về cùng một hệ trục tọa độ. Để thực hiện được v

File đính kèm:

luan_an_ve_mo_hinh_nhan_dang_tu_the_vo_dua_tren_anh_chieu_sa.pdf

luan_an_ve_mo_hinh_nhan_dang_tu_the_vo_dua_tren_anh_chieu_sa.pdf 6_ThongTinTomTat_Viet_NTT.pdf

6_ThongTinTomTat_Viet_NTT.pdf 7_ThongTinTomTat_English_NTT.pdf

7_ThongTinTomTat_English_NTT.pdf luanvan_abstract_vietnamesedangbao.pdf

luanvan_abstract_vietnamesedangbao.pdf TRÍCH YẾU LUẬN ÁN_NTT.pdf

TRÍCH YẾU LUẬN ÁN_NTT.pdf