Luận án Xây dựng mô hình nhận dạng kết hợp nhằm nâng cao độ chính xác phân loại tín hiệu điện tim loạn nhịp

Trang 1

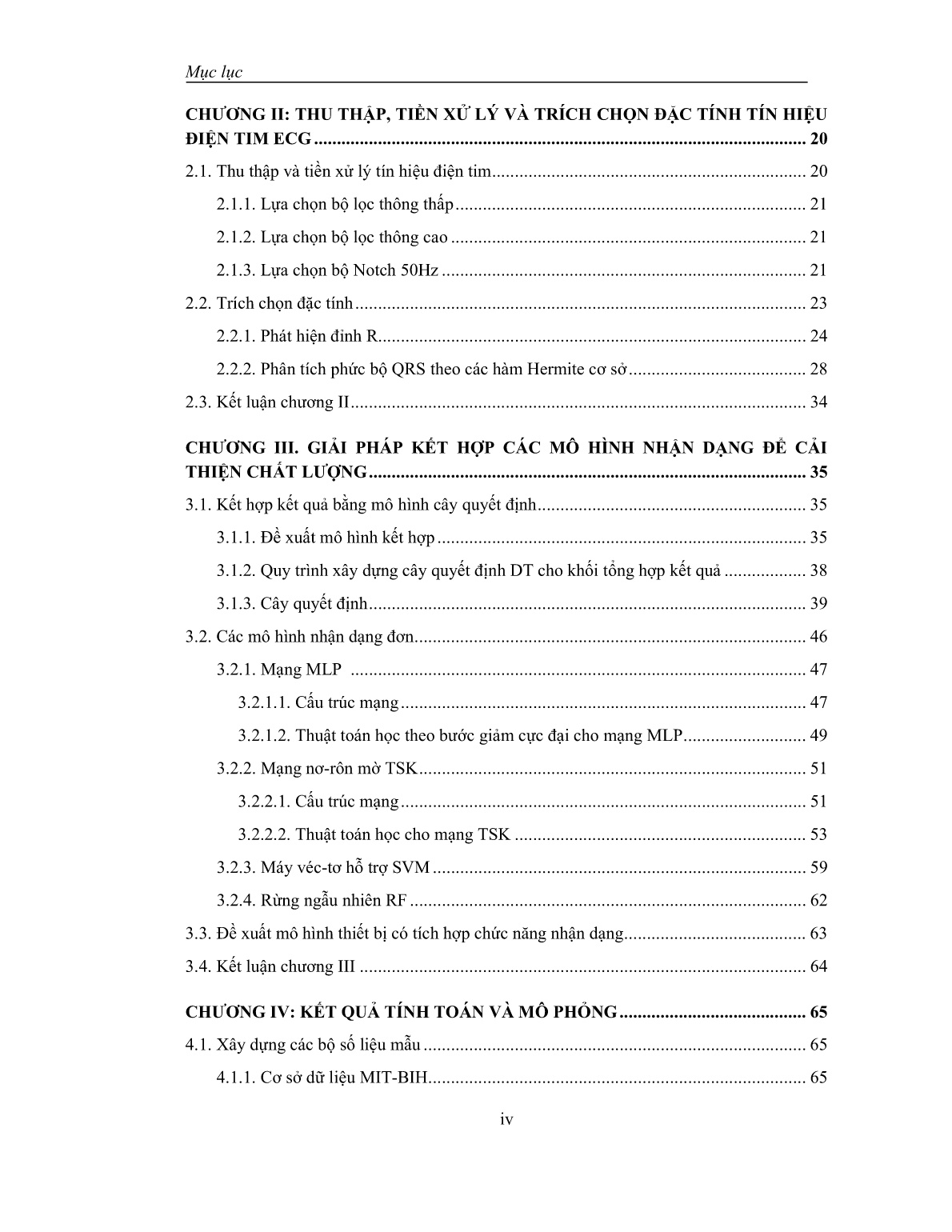

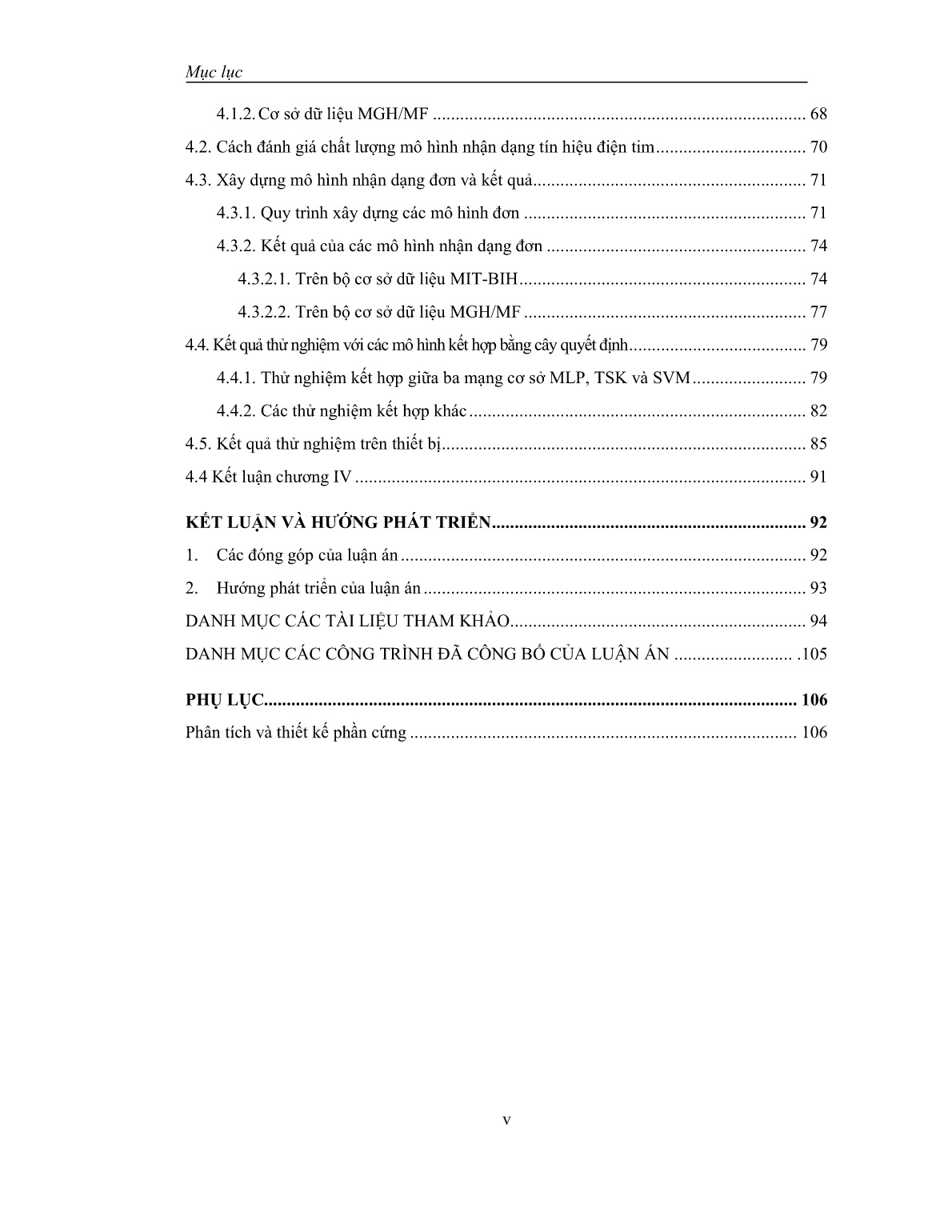

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Bạn đang xem 10 trang mẫu của tài liệu "Luận án Xây dựng mô hình nhận dạng kết hợp nhằm nâng cao độ chính xác phân loại tín hiệu điện tim loạn nhịp", để tải tài liệu gốc về máy hãy click vào nút Download ở trên.

Tóm tắt nội dung tài liệu: Luận án Xây dựng mô hình nhận dạng kết hợp nhằm nâng cao độ chính xác phân loại tín hiệu điện tim loạn nhịp

8 2 Tổng 24 6 Thực hiện theo quy trình đã trình bày ở mục trên (3.1.1. Xây dựng mô hình kết hợp), cụ thể: Kết quả nhận dạng của ba mô hình đơn MLP là y1 , TSK là y2, SVM là y3; Số mô hình M=3, số lớp K=3, số mẫu dùng để học là 28 (theo bảng 3.4), nên kết quả của mô hình nhận dạng đơn có dạng: 1 2 3...i i i iy y y y Véc-tơ tổng có kích thước là 9 ( )M K , thể hiện trong bảng 3.5: Số mẫu học là từ dòng 1-24, số mẫu kiểm tra từ dòng 25-30. 1 2 3 11 12 13 21 22 23 31 32 33learn y y y y y y y y y Y y y y Như vậy, bộ số liệu học cho cây quyết định DT là ,learn learn learn Y d d là các mã loại nhịp tim đã biết trước, trong bảng 3.5 là dòng cuối cùng (Type d) có các mã (1- Loại nhịp bình thường N, 2- Loạn nhịp trên thất S, 3- Ngoại tâm thu thất S); Từ bộ số liệu trên ta tiến hành xây dựng cấu trúc cây quyết định, kết quả thể hiện trong hình 3.7. Bảng 3.5: Bảng số liệu học và kiểm tra cho Ví dụ 2 ID Véc-tơ tổng Y có kích thước (1x3*3) Type d y1 y2 y3 y11 y12 y13 y21 y22 y23 y31 y32 y33 1 0.624 0.087 0.290 0.378 -0.053 0.901 0.579 0.210 0.211 1 2 0.612 0.151 0.237 0.439 0.031 0.682 0.581 0.210 0.209 1 Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 45 - 3 0.432 0.502 0.067 0.610 0.210 0.123 0.775 0.178 0.047 1 4 1.083 0.081 -0.165 0.556 0.470 0.083 0.462 0.493 0.045 1 5 0.468 0.512 0.019 0.542 0.510 -0.130 0.400 0.565 0.035 1 6 0.082 0.877 0.042 0.264 0.697 -0.158 0.471 0.454 0.075 1 7 0.857 0.029 0.114 0.205 -0.181 0.337 0.936 0.032 0.032 1 8 0.587 -0.319 0.731 0.759 -0.090 0.378 0.707 0.112 0.181 1 9 0.205 0.723 0.072 0.426 0.619 -0.067 0.716 0.214 0.070 2 10 0.353 0.723 -0.076 0.095 1.085 -0.097 0.578 0.387 0.035 2 11 -0.006 0.952 0.053 0.260 0.836 -0.068 0.633 0.326 0.041 2 12 0.140 0.774 0.086 0.451 0.553 -0.073 0.684 0.249 0.066 2 13 0.104 0.855 0.040 0.409 0.180 -0.086 0.278 0.621 0.101 2 14 -0.077 1.385 -0.308 0.363 0.238 0.163 0.106 0.841 0.053 2 15 -0.197 0.839 0.358 -0.067 0.372 0.509 0.180 0.639 0.181 2 16 0.170 0.768 0.062 0.419 0.345 0.485 0.295 0.535 0.170 2 17 0.218 0.416 0.366 -0.013 0.098 0.975 0.096 0.102 0.802 3 18 0.457 0.136 0.407 0.016 0.191 1.187 0.083 0.088 0.829 3 19 0.194 0.399 0.407 0.364 0.221 0.316 0.218 0.194 0.588 3 20 0.035 0.110 0.854 0.163 0.190 0.145 0.210 0.221 0.568 3 21 0.181 -0.128 0.947 0.422 0.160 0.045 0.293 0.191 0.516 3 22 0.076 0.123 0.801 0.451 0.265 0.030 0.269 0.214 0.517 3 23 0.208 0.162 0.631 0.634 0.174 0.177 0.401 0.170 0.430 3 24 -0.272 0.301 0.972 0.210 0.136 0.145 0.088 0.073 0.839 3 25 0.952 -0.023 0.072 0.143 0.260 0.600 0.677 0.115 0.208 ? 26 0.674 -0.097 0.424 0.085 0.287 0.293 0.544 0.254 0.202 ? 27 0.157 0.746 0.096 -0.007 0.431 0.445 0.212 0.574 0.214 ? 28 -0.101 0.655 0.447 0.178 0.221 0.656 0.242 0.554 0.203 ? 29 0.076 0.286 0.638 0.234 0.437 0.086 0.109 0.162 0.730 ? 30 0.236 0.204 0.560 0.271 0.366 0.351 0.324 0.181 0.495 ? Hình 3.7: Cấu trúc cây quyết định tạo ra từ bộ số liệu trong bảng 3.5 Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 46 - Decision tree for classification 1 if y9=0.320361 then node 3 else 1 2 if y1=0.392107 then node 5 else 1 3 class = 3 4 if y6=-0.127086 then node 7 else 2 5 class = 1 6 class = 1 7 class = 2 Trong bảng 3.6 là kết quả nhận dạng với sáu mẫu mới (từ dòng 25-30 trong bảng 3.5). Bảng 3.6: Kết quả nhận dạng của Ví dụ 2 ID Kết quả nhận dạng bằng cây quyết định 25 1 26 1 27 2 28 2 29 3 30 3 3.2. Các mô hình nhận dạng đơn Trong luận án, nghiên cứu sinh sử dụng bốn mô hình nhận dạng đơn, đó là mô hình MLP, TSK, SVM và RF. Như đã trình bày ở trên, lý do sự lựa chọn các mô hình đơn này là: Trong các hệ thống tổng hợp ý kiến, số khối đơn vị thường phải lớn hơn hai (để tránh trường hợp hai khối đưa ra kết quả trái ngược thì không biết nên theo kết quả của khối nào). Hệ thống ba khối nhận dạng đơn là vừa đủ, không quá phức tạp cho các thử nghiệm trong luận án; Các mạng được lựa chọn đều là các mạng rất kinh điển, đã được sử dụng trong rất nhiều ứng dụng xử lý tín hiệu nói chung và trong các bài toán nhận dạng nói riêng; Luận án có được bộ mẫu chi tiết và các kết quả của cả ba mạng MLP, TSK, SVM đã được báo cáo trong các bài báo của hội thảo và tạp chí quốc tế (trong đó có các công trình đăng trên IEEE Transactions on Biomedical Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 47 - Engineering) [70]. Xét về các mô hình đơn lẻ, cho tới hiện nay cũng rất ít có các công trình khác có thể đạt được độ chính xác cao hơn các mô hình này khi nhận dạng đồng thời cả 7 mẫu bệnh. Nếu giải pháp của nghiên cứu sinh đề xuất có thể đạt đươc độ chính xác cao hơn nữa thì sẽ làm minh chứng rất tốt cho chất lượng của đề xuất trong luận án. Sau đây, sẽ lần lượt giới thiệu tóm tắt về cấu trúc, thuật toán xây dựng các mạng dựa trên các quá trình học của bốn mạng cơ sở này. 3.2.1 . Mạng MLP 3.2.1.1. Cấu trúc mạng Mạng MLP là mạng nơ-rôn phổ biến nhất, nó là một mạng truyền thẳng với các phần tử cơ bản gọi là nơ-rôn [5]. Trong luận án sử dụng mạng MLP với một lớp ẩn được trình bày trong hình 3.8. Nhiệm vụ đặt ra là phải xác định cấu trúc cố định cho mạng MLP: Số lớp ẩn, hàm truyền đạt của mỗi lớp, số lượng nơ-rôn trên mỗi lớp, trọng số ghép nối giữa nơ-rôn trong mô hình MLP có thể được điều chỉnh lại cho phù hợp trong quá trình học để xuất các tín hiệu đầu ra mong muốn. Thuật toán của quá trình học được sử dụng cho mô hình MLP trong luận án này đã được đề xuất bởi Levenberg và Marquardt [5, 83]. Hình 3.8: Mạng MLP với một lớp ẩn Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 48 - Theo [5] mạng MLP với một lớp ẩn có thể được đặc trưng bởi các thông số sau: Bộ ba ( , , )N M K , trong đó N – số đầu vào, M – số nơron thuộc lớp ẩn, K – số nơ-rôn ở lớp đầu ra. Các hàm truyền đạt 1f của lớp ẩn và 2f của lớp đầu ra. Ma trận trọng số W kết nối giữa lớp đầu vào và lớp ẩn ( ijW - trọng số ghép nối giữa nơ-rôn ẩn thứ i và đầu vào thứ j), ma trận các trọng số V kết nối giữa lớp ẩn và lớp đầu ra ( ijV trọng số ghép nối giữa nơ-rôn đầu ra thứ i và nơ-rôn ẩn thứ j). Khi đó, với véc-tơ đầu vào 1 2, , , Nx x x x (đầu vào phân cực cố định x0=1) ta có đầu ra được xác định tuần tự theo chiều “lan truyền thuận” như sau: (1) Tổng đầu vào của nơ-rôn ẩn thứ i (i=1,2,...,M): 0 N i j ij j u x W (3.5) (2) Đầu ra của nơ-rôn ẩn thứ i (i=1,2,...,M), đầu vào phân cực của các nơ-rôn lớp ra là 0 1v . 1i iv f u (3.6) (3) Tổng đầu vào của nơ-rôn đầu ra thứ i (i=1,2,...,K): 0 M i j ij j g v V (3.7) (4) Đầu ra thứ i (i=1,2,...,K) của mạng sẽ bằng: 2i iy f g (3.8) Tổng hợp lại ta có hàm truyền đạt của mạng MLP là một hàm phi tuyến có công thức như sau: 2 2 ij 2 1 ij 2 1 ij 0 0 0 0 W M M M N i i j j k jk j j j k y f g f v V f f u V f f x V (3.9) Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 49 - 3.2.1.2. Thuật toán học theo bước giảm cực đại cho mạng MLP Quá trình điều chỉnh các thông số của mạng để thích nghi với bộ số liệu được gọi là quá trình học của mạng MLP hay còn được gọi là quá trình huấn luyện (train) mạng MLP theo một bộ mẫu cho trước [5]. Trong số các thông số đã nêu ở trên, nếu như các thông số cấu trúc (số đầu vào, số đầu ra, số lớp ẩn, các hàm truyền đạt của mỗi lớp ẩn, số nơ–rôn trên mỗi lớp ẩn) thường được chọn bằng thực nhiệm hoặc bằng phương pháp thử với các giá trị rời rạc nhất định thì các thông số trọng số ghép nối giữa các nơ–rôn có thể được điều chỉnh thích nghi bằng các thuật toán tối ưu hóa (còn gọi là thuật toán “học”). Các thuật toán “học” của mạng nơ–rôn có các ý tưởng cũng hoàn toàn tương tự như các thuật toán học của nơ–rôn, tuy nhiên cần chú ý rằng mức độ phức tạp của công thức là cao hơn do cấu trúc mạng nơ–rôn phức tạp hơn so với từng nơ–rôn đơn lẻ. Tương tự như đối với nơ–rôn đơn lẻ, các thuật toán thông dụng nhất để điều chỉnh thích nghi các trọng số của một mạng nơ–rôn là các thuật toán sử dụng gradient như thuật toán bước giảm cực đại, thuật toán Levenberg – Marquardt, Khi sử dụng thuật toán bước giảm cực đại, ta cũng khởi tạo các giá trị trọng số bằng các giá trị ngẫu nhiên nào đó: (0) (0); . W W V V Sau đó ta sẽ xây dựng công thức lặp để điều chỉnh liên tiếp các giá trị này để hàm sai số tiến tới cực trị. Ta có các công thức thay đổi các trọng số trong hai ma trận W và V để xác định điểm cực trị của hàm mục tiêu E như sau: ( 1) ( ) ( 1) ( ) t t t t EW W W EV V V (3.10) với hàm mục tiêu E cho theo (3.7) và độ lệch giữa véc–tơ đầu ra iy của mạng MLP và véc–tơ giá trị đích id được tính theo các công thức tính khoảng cách như các công thức từ (3.8) đến (3.12). Từ các công thức (3.1) đến (3.5) và (3.7) đã nêu trên ta có: Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 50 - 1 1 p K ij ij ij i j yE y d V V (3.11) trong đó: 2 2 0 M ij ij jk ij ij ik k y g V f g f g v V V V (3.12) nhưng 1jk V V chỉ khi j và k , 0jk V V trong các trường hợp còn lại. Từ đó: 2 1 p i i i i i E y d f g v V (3.13) Một cách tương tự: 2 1 1 1 p K ij ij ij j i i i j E y d f g V f u x W (3.14) Với các công thức gradient này, ta có thể tiến hành điều chỉnh thích nghi các giá trị của hai ma trận W và V để tìm cực tiểu của hàm sai số. Ta có các công thức để điều chỉnh thích nghi các trọng số của mạng MLP theo thuật toán Levenberg – Marquardt [4]: 1( 1) ( ) ( ) ( )t t t t W W H W g W (3.15) 1( 1) ( ) ( ) ( )t t t t V V H V g V (3.16) trong đó: ( ) ( ),t t W V các ma trận chứa các trọng số ghép nối ijW và ijV tại bước lặp thứ (t) trong quá trình điều chỉnh thích nghi; g W và g V – véc–tơ gradient của hàm sai số theo từng trọng số trong các ma trận; Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 51 - H W và H V – ma trận gradient bậc hai của hàm sai số theo từng cặp trọng số từ các ma trận W và V tương ứng. 3.2.2 . Mạng nơ-rôn mờ TSK 3.2.2.1. Cấu trúc mạng Để tái tạo lại các phương pháp tính toán của mô hình TSK, các tác giả Takagi, Sugeno và Kang đã xây dựng một mô hình tính toán dưới dạng tương tự như một mạng truyền thẳng với cấu trúc như trên hình 3.4. Để đơn giản hóa mô hình và các công thức, ta tạm xét mạng có một đầu ra [4, 5]. Về mặt cấu trúc, mạng TSK được xác định bởi ba thông số , ,N M K với N số đầu vào (số thành phần của véc–tơ x ), M số quy tắc suy luận, K số đầu ra (đang tạm xét là 1) và mạng TSK là một mô hình gồm năm lớp. Lớp đầu tiên được gọi là lớp mờ hóa, sử dụng để tính toán các giá trị điều kiện mờ thành phần: 21 1 iji j ij b j ij ij W x A x A (3.17) Khi sử dụng hàm truyền đạt là hàm Gauss mở rộng, mỗi một khối i j ijW x A sẽ có ba véc–tơ thông số là 1 2, , ,i i i iNA A A A – véc–tơ trọng tâm của quy tắc, 1 2, , ,i i i iN σ véc–tơ thông số độ rộng của quy tắc, 1 2, , ,i i i iNb b b b véc–tơ thông số hình dạng của quy tắc. Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 52 - Hình 3.9: Mạng nơ–rôn mờ TSK (1) Lớp thứ hai là lớp tính giá trị điều kiện lô–gic mờ tổng hợp cho toàn bộ véc– tơ đầu vào ( )W x A . Theo (3.15) ta có: 1 1 1 2 2 2 2 1 1 1 i N N N N b i i i i W W x A W x A W x A x A x A (3.18) nên lớp thứ hai này chỉ đơn giản là các khối nhân các tín hiệu đầu vào i i iW x A để tạo ra tín hiệu đầu ra tương ứng. (2) Lớp thứ ba được sử dụng để tính toán giá trị các hàm TSK ( )if x (là các hàm tuyến tính 0 1 N i ij j j q q x ) và nhân với giá trị mờ của điều kiện lô–gic ( )iW x A . Lớp này có chứa các thông số cần xác định là các hệ số ijq (với 1, 2, ,i M – số luật của mạng và 0,1, ,j N – số đầu vào của mạng) của các hàm tuyến tính TSK; (3) Lớp thứ tư dùng để tính toán tổng các giá trị của lớp ba (F1) và lớp hai (F2) trong mạng để có được các thành phần tử số và mẫu số trong công thức (3.16); (4) Lớp cuối cùng chỉ có duy nhất một khối chia để tính toán giá trị đầu ra của toàn mạng theo công thức: Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 53 - 11 2 1 M i i i M i i W y Fy F W x A x A (3.19) 3.2.2.2. Thuật toán học cho mạng TSK Cũng tương tự như đối với mạng MLP, mạng TSK học theo nguyên tắc “có hướng dẫn”, nghĩa là ứng với mỗi đầu vào ta sẽ có một giá trị đầu ra tương ứng từ mạng. Vì vậy, khi ta có một bộ số liệu gồm p mẫu ,i ix d với 1, 2, , ;i p ;N Ki i x d , cần xây dựng một mạng TSK xấp xỉ bộ số liệu mẫu này sao cho: : i i ii TSK y x d (3.20) hoặc ta tìm cực tiểu của hàm sai số: 2 1 1 min 2 p i i i E y d (3.21) Từ mô tả cấu trúc năm lớp của mạng TSK ở trên, ta thấy rằng mạng chỉ có hai lớp có chứa các thông số có thể điều chỉnh thích nghi theo bộ số liệu được, đó là lớp thứ nhất với các khối mờ hóa và lớp thứ ba với các hàm TSK tuyến tính. Các lớp thứ hai, thứ tư và thứ năm đều có cấu hình cố định, không phụ thuộc vào bộ số liệu. Với mạng có N đầu vào, M quy tắc suy luận và K đầu ra, ta có số lượng thông số của các khối mờ hóa là 3 M N (và đây là các thông số phi tuyến), số lượng các thông số của các hàm tuyến tính TSK là: ( 1)M N K . Do đó ta có thể nhận thấy số lượng các tham số của mạng TSK là khá lớn. Việc tối ưu hóa hàm sai số (3.20) với số lượng lớn các tham số như vậy sẽ rất phức tạp, thời gian tính toán lâu và xác suất để quá trình hội tụ về một điểm cực tiểu tốt là thấp. Vì vậy một thuật toán hỗn hợp đã được đề xuất trong [70], theo đó ta tách quá trình chỉnh thích nghi thành hai quá trình con: Điều chỉnh các thông số tuyến tính và điều chỉnh các thông số phi tuyến. Thuật toán điều chỉnh chung được mô tả như sau: (1) Khởi tạo các giá trị ban đầu của các thông số phi tuyến và tuyến tính; Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 54 - (2) Giữ nguyên giá trị các thông số tuyến tính, sử dụng thuật toán (lặp) điều chỉnh các thông số phi tuyến (số bước lặp được lựa chọn trước, thường khoảng 5 tới 10 bước); (3) Giữ nguyên các giá trị của các thông số phi tuyến, sử dụng thuật toán điều chỉnh các thông số tuyến tính. Kiểm tra hàm sai số mục tiêu, nếu kết quả đã đạt yêu cầu thì dừng quá trình học, ngược lại thì quay lại bước 2. a) Thuật toán điều chỉnh các thông số phi tuyến Theo [5], ta có thể sử dụng nhiều thuật toán tối ưu hóa khác nhau cũng như đối với mạng MLP. Thuật toán cơ bản nhất là thuật toán bước giảm cực đại sử dụng gradient bậc nhất. Phần tiếp theo đây ta sẽ trình bày về thuật toán bước giảm cực đại để điều chỉnh các thông số phi tuyến. Với bộ số liệu gồm p mẫu ,i idx với 1,2, , ; ;Ni ii p d x (tạm xét với mạng có một đầu ra), khi cho véc–tơ đầu vào 1 2, , ,i i i iNx x x x , ta có đầu ra từ mạng TSK được tuần tự tính theo các công thức từ (6.42) đến (6.46) như sau: 1. Tính các giá trị mờ thành phần: 21 1 kjkj ij kj b ij kj kj W x A x A cho 1, 2, , ;k M và 1, 2, , .j N 2. Tính giá trị điều kiện toàn phần cho 1, 2, , :k M 1 1 1 2 2 2 2 1 1 1 kj k i k k i k k i k kN iN kN N b j ij kj kj W W x A W x A W x A x A x A 3. Tính đáp ứng đầu ra theo các công thức: 1 1 ( ) M k i k k i k i M k i k k W f y W x A x x A (3.22) Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 55 - Sau khi có được p giá trị đầu ra, ta tính được giá trị hàm sai số mục tiêu là: 2 1 1 2 p i i i E y d (3.23) Khi đó, thuật toán bước giảm cực đại áp dụng vào để thực hiện tối thiểu hóa hàm sai số E sẽ điều chỉnh các thông số phi tuyến như sau: ( 1) ( )t t EA A A ( 1) ( )t t E (3.24) ( 1) ( )t t Eb b b cho 1, 2, , ; 1, 2, , .M N Ta có từ hàm sai số 2 1 1 2 p i i i E y d có thể xác định các gradient tuần tự như sau. Để rút gọn, ta ký hiệu ki k i kW x A là giá trị điều kiện toàn phần của luật thứ k ứng với mẫu đầu vào thứ i trong bộ số liệu đã cho. Với các hệ số trọng tâm ta có: 1 1 1 1 1 2 1 1 ( ) ( ) p i i i i M M ki k i kiM M k k ki ki k i k k p i i Mi ki k yE y d A A f f A A y d x x (3.25) Ta có: Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 56 - 1 ( ) ( )( ) ( ) M ki k i i ii ik i i f W ff A A A W f A x x A xx x A x (3.26) và: (3.27) do hệ số A chỉ xuất hiện trong công thức tính iW x A . Rút gọn công thức (3.22) ta có: 1 1 2 1 1 1 1 2 1 1 ( ) ( ) ( ) ( ) ( M M i i i ki ki k ip k k i i Mi ki k M M i ki ki k ip ik k i i Mi ki k ki i i W W f f A AE y d A f f W y d A f y d x A x A x x x x x A 1 2 1 1 ) ( ) M i k ip ik Mi ki k f W A x x x A (3.28) Theo công thức (3.16) ta có: 1 1 1 2 2 2 1 i i i N iN N Nia i j ij j j j W W x A W x A W x A W x AW W x A A A x A x A (3.29) 1 1 M M ki k i k ik k W W A A A x A x A Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 57 - Với hàm truyền đạt Gauss mở rộng: 21 1 i b i W x A x A ta có đạo hàm của hàm truyền đạt theo các thông số trọng tâm A của luật là: 2 1 0 i i i i i b W x A W x A khi x AW x A A khi x A (3.30) Đạo hàm của hàm truyền đạt theo thông số hình dạng b của luật là: 2ln 1 0 i i i i i x A W x A W x A khi x AW b khi x A (3.31) và theo các thông số độ mở là: 2 1i iW b W x A W x A (3.32) Từ đó ta có: 1 1 2 1 0 2 1 0 N ii j ij j j j N j ij j i i j j i i i i i W x AW W x A A A b W W W x A khi x A x A khi x A b W W khi x A x A khi x A x A x A Chương III: Giải pháp kết hợp các mô hình nhận dạng để cải thiện chất lượng - 58 - (3.31) Sử dụng các công thức (3.25) và (3.28), ta có công thức tính gradient của hàm sai số E theo các trọng tâm của các hàm mờ hóa. Tương tự như vậy chúng ta sẽ có các công thức cho gradient của hàm sai số E theo các thông số độ mở và các thông số hình dạng b . b) Thuật toán điều chỉnh thích nghi các thông số tuyến tính Theo [5], để xác định các thông số tuyến tính, trước tiên ta biểu diễn hàm sai số E dưới dạng một hàm tuyến tính của các thông số này. Mạng TSK có các thông số tuyến tính là các hệ số q được sử dụng trong các hàm ( )if x , cụ thể 0 1 ( ) N i j ij j f q q x x . Với 1,2, , M , 0,1, , N và K đầu ra ta có số lượng thông số tuyến tính là 1M N K . Các công thức sau đây được trình bày cho trường hợp mạng có một đầu ra ( 1K ). Nếu đặt đầu vào phân cực 0 1 1,2, ,Mix i , ta có 0 ( ) N i j ij j f q x x . Biểu diễn tín hiệu đầu ra theo các thông số tuyến tính này ta có: 1 01 1 1 0 1 1 0 1 1 ( ) 1 1 M NM k i k kj ijk i k k i k jk i M M k i k k i k k k N M k i k kj ijM j k k i k k N M kj k i k ijM j k k i k k W q xW f y W W W q x W q W x W

File đính kèm:

luan_an_xay_dung_mo_hinh_nhan_dang_ket_hop_nham_nang_cao_do.pdf

luan_an_xay_dung_mo_hinh_nhan_dang_ket_hop_nham_nang_cao_do.pdf 2018_08_15_THONG TIN DUA LEN MANG.pdf

2018_08_15_THONG TIN DUA LEN MANG.pdf 2018_08_15_TOM TAT.pdf

2018_08_15_TOM TAT.pdf 2018_08_15_TRICH YEU LUAN AN.pdf

2018_08_15_TRICH YEU LUAN AN.pdf