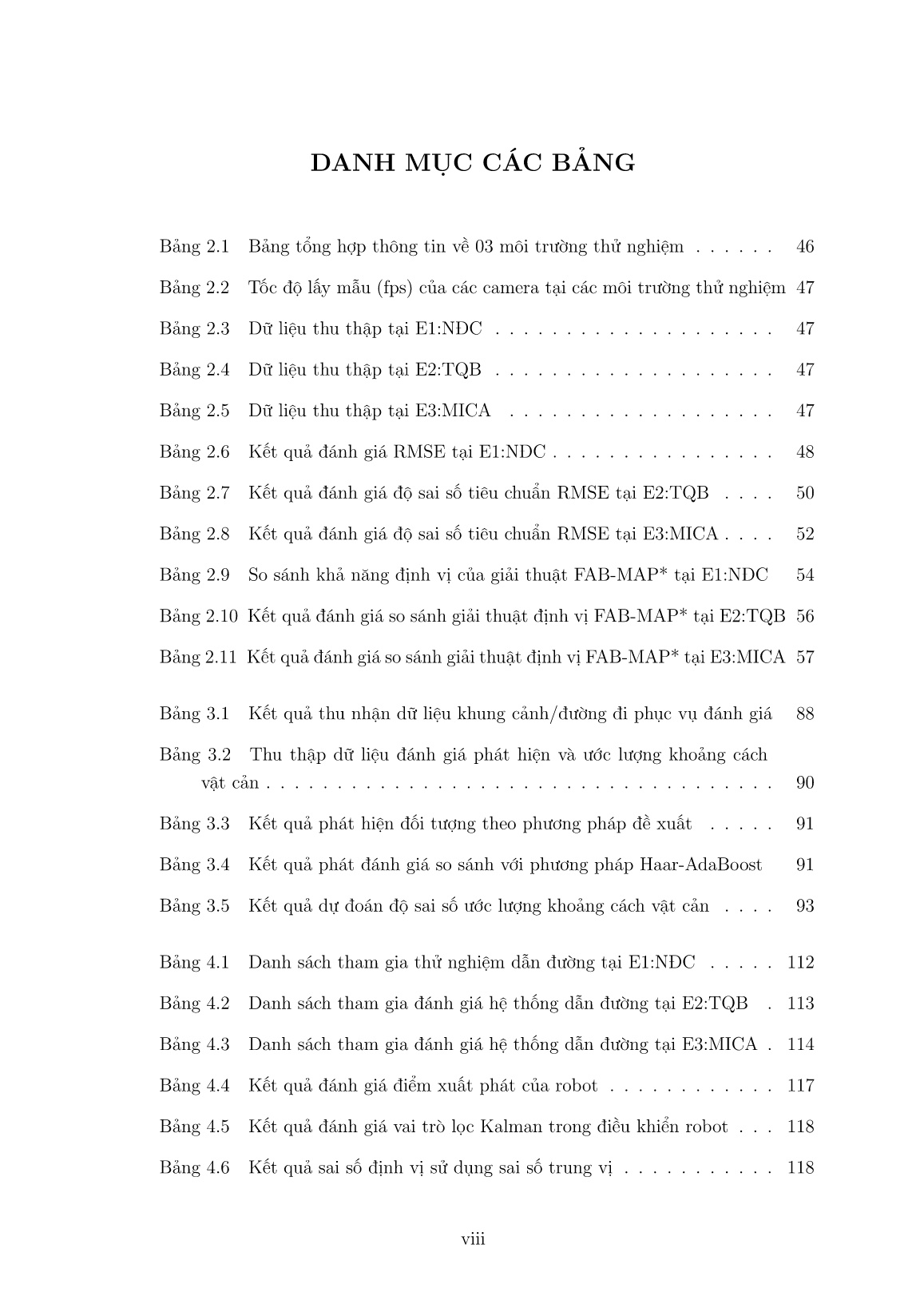

Luận án Nghiên cứu và phát triển một số kỹ thuật định vị dựa trên hình ảnh, ứng dụng trợ giúp dẫn đường cho người khiếm thị

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Bạn đang xem 10 trang mẫu của tài liệu "Luận án Nghiên cứu và phát triển một số kỹ thuật định vị dựa trên hình ảnh, ứng dụng trợ giúp dẫn đường cho người khiếm thị", để tải tài liệu gốc về máy hãy click vào nút Download ở trên.

Tóm tắt nội dung tài liệu: Luận án Nghiên cứu và phát triển một số kỹ thuật định vị dựa trên hình ảnh, ứng dụng trợ giúp dẫn đường cho người khiếm thị

ới giải thuật 2, trong đó Hàm getProb-

ability() trả về kết quả là số cặp điểm đặc trưng và ma trận H. Nếu ma trận H

trả về giá trị NULL có nghĩa là vùng đang xét không khớp với mẫu đối tượng.

Nếu ma trận H nếu khác NULL, tức là vùng đang xét khớp với đối tượng. H sẽ

được sử dụng để tính lại 4 góc của đối tượng trên ảnh Ik của quan sát hiện thời.

73

3.4.1.3 Xác định vùng chứa đối tượng

Mục đích của việc này là xác định vị trí của đối tượng trên ảnh Ik của quan sát

∗

hiện tại. Từ 4 góc của vật cản trên ảnh Ik, xác định 4 góc vật cản trên ảnh Ik

thông qua ma trận H vừa tính ở trên.

Giải thuật 3: Xác định vùng chứa đối tượng

Function FindObjectLocation(Rect object.rect, Mat H)

Rect r=object.rect;

Point ptl=Point(r.x,r.y)∗H //Góc trên bên trái (top-left)

Point ptr=Point(r.x+r.width,r.y)∗H //Góc trên bên phải (top-right)

Point pbr=Point(r.x+r.width,r.y+r.height)∗H //Góc dưới bên phải

(bottom-right)

Point pbl=Point(r.x,r.y+r.height)∗H //Góc dưới bên trái (bottom-left)

Rect r2= findBoundingbox(ptl,ptr,pbr,pbl)

Return r2;

Kết quả xác định vật cản cố định được minh họa ở Hình 3.9, trong đó tâm của

đối tượng được xác định ở sử dụng kỹ thuật đối sánh ảnh (FLANN matching)

xác định đối tượng trong ảnh hiện thời.

a) Aûnh trong CSDL (I ) b) Quan saùt hieän taïi (AÛnh I )

z{ z

Hình 3.9 Minh họa kết quả xác định vùng chứa đối tượng

∗

Hình 3.9(a) ảnh Ik chứa đối tượng với các điểm đặc trưng trích chọn và vùng chữ

nhật khoanh đối tượng từ trước. Hình 3.9(b) là ảnh Ik với các điểm đặc trưng

tương ứng. Kết quả hình chữ nhật màu đỏ, khoanh vùng đối tượng chuẩn hóa

bao lấy đối tượng và sử dụng kỹ thuật biến đổi hình học để chuẩn hóa về đa giác

màu xanh.

74

3.4.2 Phát hiện vật cản động

Đối với vật cản động, chúng tôi đề xuất phát hiện người (di chuyển với tốc độ

trung bình với vận tốc v=1.4m/s [18]) là đối tượng hay gặp trong các tình huống thử

nghiệm tại các môi trường thực tế. Đây là chủ đề thu hút được nhiều nghiên cứu

trong thời gian gần đây [120] nhằm nâng cao hiệu năng nhận dạng phải kể đến một

số phương pháp: HoG-SVM của Hongming Zhang 2006 [140] đạt 96%; HoG-AdaBoost

của Makoto Arie 2011 [2] đạt 96%; Haarlike-SVM của A. Mohan 2001 [93] đạt 78%;

Geometric features- AdaBoost của K. Mikolajczyk 2004 [92] đạt 87%; PCA-SVM của

Thomas Deselaers 2005 [33] đạt 59%.

Căn cứ vào kết quả đánh giá, chúng tôi lựa chọn phương pháp sử dụng kết hợp

HoG-SVM [30] [26] cho trong bài toán phát hiện người bởi tính phổ dụng và tính hiệu

quả của nó trong nhiều ứng dụng. Phần dưới đây chúng tôi phân tích kỹ hơn về phương

pháp này.

Mô hình

Huấn luyện Huấn luyện

Ảnh

huấn luyện

Trích chọn đặc trưng HoG Bộ phân loại SVM

Tính toán Tính HoG Chuẩn hóa

Tiền xử lý Gradient trên các Cell Block Nhận dạng

bc bc bc bc

1 2 3 4

Ảnh

nhận dạng

Kết quả

Hình 3.10 Sơ đồ các bước phát hiện người sử dụng HoG-SVM

Hình 3.10 các bước tính toán phát hiện người sử dụng kết hợp HoG-SVM, trong

đó mũi tên nét đứt là quá trình học, mũi tên nét liền là quá trình nhận dạng. Ảnh đầu

vào dùng cho huấn luyện và nhận dạng trước khi được tính Gradient, cần phải đưa về

kích thước chuẩn. Ngoài ra, để tránh gây khó khăn cho việc nhân dạng đối tượng sau,

các ảnh cần phải được chuẩn hóa màu, chuẩn hóa gamma (bước tiền xử lý) của giải

thuật.

3.4.2.1 Trích chọn đặc trưng HoG

Đặc trưng HoG [30] biểu diễn sự phân bố theo hướng của các vector Gradient.

HoG được tính bằng cách chia ảnh thành các vùng không gian nhỏ hơn gọi là cell. Mỗi

cell tích lũy histogram 1 chiều cục bộ của hướng gradient hoặc định hướng biên trên

75

các điểm ảnh của các cell. Các cell nằm cạnh nhau được gộp lại thành một khối gọi

là block. Các block có thể chồng lấp lên nhau với mục đích tăng cường mối quan hệ

trong không gian giữa các điểm ảnh. Các histogram của khối được kết hợp với nhau

tạo thành vector đặc trưng.

Phương pháp tổng quan để tính toán đặc trưng HoG trên một cửa sổ bất kỳ được

thực hiện như sau:

+ Phân chia cửa sổ (window) cần tính HoG thành nhiều khối (block). Mỗi khối

gồm nhiều ô (cell), các ô phải có kích thước và có số lượng ô trong mỗi khối bằng

nhau.

+ Các khối được đặt chồng lên nhau, khoảng cách giữa hai khối con liên tiếp nhau

là một hằng số.

Theo Navneet Dalal [30] thì các bước trích chọn đặc trưng HoG thực hiện qua 3

bước: (1) Tính toán Gradient; (2) Tính giá trị HoG trên các Cell; (3) Chuẩn hóa Block.

Chi tiết các kỹ thuật này có trong PHỤ LUC A.5 của luận án.

3.4.2.2 Bộ phân loại SVM

Ảnh sau khi trích chọn đặc trưng sẽ được đưa vào bộ huấn luyện SVM để đưa ra

được mô hình huấn luyện. Bộ phân lớp nhị phân (người/không người) sẽ được học từ

các tập ảnh cho trước và sử dụng trong quá trình phát hiện với khung hình hiện tại.

Gọi S là một tập gồm có l mẫu học:

l

S = {(x1,y1), (x2,y2), (x3,y3)...(xl,yl)} ⊆ (X × Y ) (3.2)

n

Với một vector đầu vào n chiều xi ∈ R thuộc lớp I hoặc lớp II (tương ứng nhãn yi =1

đối với lớp I và yi = −1 đối với lớp II).

Đối với các dữ liệu phân chia tuyến tính, chúng ta có thể xác định được siêu phẳng

f(x) chia tập dữ liệu thành hai lớp I và II. Cụ thể, nếu f(x) ≥ 0 kết luận x thuộc lớp

(+) và f(x) < 0 kết luận x thuộc lớp (-).

n

f(x)= wx + b = wjxj + b (3.3)

j=1

X

yif(xi)= yj(wxi + b) ≥ 0, i =1..l (3.4)

Trong đó w là vector pháp tuyến n chiều và b là giá trị ngưỡng.

76

3.5 Uớc lượng khoảng cách vật cản

3.5.1 Nguyên lý ước lượng khoảng cách

Mục đích của việc dự đoán khoảng cách là tái tạo lại không gian 3 chiều (3D),

mô phỏng lại hệ thống thị giác của con người thông qua việc lấy đồng thời ảnh từ hai

camera cùng quan sát một khung cảnh từ các góc nhìn khác nhau. Bằng phép biến đổi

hình học sẽ tính toán được khoảng chênh lệch giữa hai quan sát trên ảnh để từ đó ước

lượng ra khoảng cách trên thực địa, được minh họa Hình 3.11.

x 0

D

ϕ

1 ϕ2

ϕ0 ϕ0

B1 B2

f B

S S

L R

Hình 3.11 Mô hình ước lượng khoảng cách vật cản từ hai quan sát

Trong đó:

+ SL và SR hai camera được đặt đồng trục trên cùng một mặt phẳng.

+ B khoảng cách nối tâm hai camera; B1 khoảng cách từ tâm chiếu đối tượng tới

camera thứ nhất, B2 khoảng cách đối camera thứ hai.

+ ϕ0 góc quan sát đối tượng từ 02 camera, ϕ1 và ϕ2 là góc giữa trục quang học của

camera và các đối tượng quan sát.

+ f tiêu cự ống kính hai camera; x0 khoảng cách vùng quan sát của camera.

Xuất phát từ khoảng cách đường nối tâm camera B được xác định từ hai thành

phần B1 và B2 ta có:

B = B1 + B2 = D tan(ϕ1)+ D tan(ϕ2) (3.5)

77

Do vậy khoảng cách ước lượng từ camera đến đối tượng tính bằng công thức sau:

B

D = (3.6)

tan(ϕ1) + tan(ϕ2)

Để xác định khoảng cách này, chúng ta sẽ phân tích hình ảnh của đối tượng (cây)

được quan sát được ở hoành độ trên ảnh x1 từ camera thứ nhất và hoành độ trên ảnh

x2 từ camera thứ hai.

x

0 x0

2 2

x1

−x2

∆D

∆ϕ

D D

ϕ2

ϕ0

D

ϕ1

ϕ

0 ϕ0

B

SL SR

(a). Goùc thöù nhaát quan saùt ñoái töôïng (b). Goùc thöù hai quan saùt ñoái töôïng (c). Buø loãi khoaûng caùch cho 1 ñieåm aûnh

Hình 3.12 Hình ảnh của đối tượng (cây) quan sát từ hai góc thu nhận

Áp dụng nguyên lý đồng dạng trong hình học như mô tả trong Hình 3.12(a-b) ta có:

x1 tan(ϕ1)

x0 = ϕ0 (3.7)

2 tan 2

� �

−x2 tan(ϕ2)

x0 = ϕ0 (3.8)

2 tan 2

� �

Thay giá trị tan(ϕ1), tan(ϕ2) trong công thức (3.7) và công thức (3.8) vào công

thức (3.6), khoảng cách D được tính toán như sau:

Bx0

D = ϕ0 (3.9)

2tan 2 (x1 − x2)

�

Với x0 là chiều rộng của ảnh, (x1 − x2) là chênh lệch (Disparity) về vị trí của đối tượng

quan sát trên camera thứ nhất và thứ hai cùng tính theo từng điểm ảnh (pixels).

78

Tuy nhiên, theo [89], [95], [137] đã chứng minh được khoảng cách D sẽ tỷ lệ nghịch

với hiệu (x1 − x2) vì vậy để bù lỗi cho góc quan sát ϕ0 thì ϕ0 tương ứng với mỗi điểm

ảnh sẽ được cộng thêm một đại lượng ∆ϕ. Tiếp tục áp dụng nguyên lý đồng dạng

trong hình học như trong Hình 3.12(c) ta có:

tan(ϕ ) ∆D + D

0 = (3.10)

tan(ϕ0 − ∆ϕ) D

Sử dụng tính đồng nhất của lượng giác cơ bản khoảng cách lỗi được tính như sau:

D2

∆D = tan(∆ϕ) (3.11)

B

Như vậy, khoảng cách dự đoán D trong công thức (3.9) biến đổi thành:

Bx0

D = ϕ0 (3.12)

2 tan( 2 + ∆ϕ)(x1 − x2)

Từ đây công thức (3.12) đưa về biểu diễn về dạng hàm mũ như sau:

D = k ∗ xd (3.13)

Trong đó:

+ k là hằng số được tính như sau:

Bx0

k = ϕ0 (3.14)

2 tan( 2 + ∆ϕ)

+ x = (x1 − x2), d là hằng số xác định giá trị độ chênh lệch (Disparity) giữa các

điểm ảnh từ hai quan sát và được tính toán trên bản đồ chênh lệch khi hai camera

quan sát đối tượng tại các góc khác nhau.

3.5.2 Xây dựng bản đồ chênh lệch

Như vậy để xác định độ sâu của đối tượng (khoảng cách từ đối tượng tới camera),

bản đồ chênh lệch giữa các điểm ảnh trên hai quan sát phải được tính toán. Một số

lượng lớn các thuật toán đã được đề xuất để giải quyết vấn đề này như trong [28] [17]

[121] [110] [142] nhằm cải thiện độ chính xác dự đoán khoảng cách. Trong ngữ cảnh

của luận án chỉ sử dụng 01 camera, chúng tôi đi theo hướng tiếp cận xác định bản đồ

79

chênh lệch sử dụng 01 camera với các bước cơ bản như sau (Hình 3.13):

Ảnh Ik Ảnh Ik

bc bc bc

1 2 3

Ảnh đầu vào Hiệu chỉnh Đối sánh

Camera Ảnh Ik−1 Ảnh Ik−1

Độ sâu

Bộ tham số bc

hiệu chuẩn 4

Các mẫu hiệu chỉnh Tính toán

(Mẫu ô bàn cờ) Mô hình độ sâu

hiệu chuẩn

Thực hiện trước khi thu thập dữ liệu

Bản đồ chênh lệch

Hình 3.13 Sơ đồ các bước tính bản đồ chênh lệch và ước lượng khoảng cách

1. Thu thập dữ liệu.

2. Hiệu chỉnh hình ảnh.

3. Đối sánh hình ảnh.

4. Tính toán độ sâu.

Phần dưới đây trình bày chi tiết các bước xây dựng bản đồ chênh lệch

3.5.2.1 Thu thập dữ liệu

Thông thường việc thu nhận hình ảnh tiến hành từ hệ thống camera kép (camera

stereo) hoặc nhiều camera [28], [111], [119] với các góc quan sát đối tượng khác nhau

nhằm hướng tới thu nhận được các hình ảnh tốt nhất. Xuất phát từ ý tưởng từ hai

camera cùng quan sát đối tượng, chúng tôi quy định và thiết lập như sau: (i) quan sát

hiện tại Ik; (ii) quan sát trước một khoảng thời gian Ik−t, với t là một khoảng thời gian

xác định trước đủ để phân biệt hai khung cảnh Ik và Ik−t, mô tả như Hình 3.14.

3.5.2.2 Hiệu chỉnh hình ảnh

Mục đích của việc hiệu chỉnh ảnh là rất cần thiết để giảm độ phức tạp tính toán

điểm ảnh tương ứng hai quan sát, quá trình này gồm có hai bước: (i) tính toán các

tham số trong và ngoài của camera; (ii) hiệu chỉnh hình ảnh thu nhận sử dụng các

biến đổi tuyến tính xoay, dịch và nghiêng hình ảnh sao cho đường epipolar của hình

ảnh liên kết theo chiều ngang.

80

Aûnh Aûnh

I I

|}~

|

L L L

Quan saùt L

Quan saùt L |

| }~

Hình 3.14 Minh họa hai quan sát khi camera chuyển động

Việc tính toán tham số trong của camera được thực hiện ở pha ngoại tuyến theo

một số công cụ đã có sẵn (xem chi tiết trong PHỤ LỤC C.2 của luận án), ở phần này

chúng tôi trình bày cách xác định đường epipolar giữa hai quan sát và biến đổi chúng

theo liên kết ngang.

− Tìm đường epipolar trên từng ảnh: các tham số của camera được định nghĩa

như sau

+ Gọi OF và OT là tâm chiếu của hai camera, F và T là cặp mặt phẳng

ảnh tương ứng. Q Q

+ Điểm P trong thế giới thực có một phép chiếu mặt phẳng ảnh F là điểm

P P

F và mặt phẳng ảnh T là điểm T . Q

+ Điểm eT gọi là điểm epipoleQ được định nghĩa là ảnh của tâm chiếu OF lên

mặt phẳng ảnh T ; eF là ảnh của tâm chiếu OT lên mặt phẳng ảnh F .

+ Đường epipolar lQF và lT là đường nối giữa hai điểm eT PT và eF PF nằmQ trong

hai mặt phẳng ảnh.

Chúng tôi thực hiện tìm các đường epipolar trên hai quan sát khi camera chuyển

động, kết quả cho thấy các đường epipolar tìm được cắt nhau qua điểm epipole

e và e′ khi chiếu lên mặt phẳng nằm ngang thì e ≡ e′ minh họa tại Hình 3.15.

− Hiệu chỉnh liên kết ngang của các epipolar: là quá trình chiếu hình ảnh

trên cùng một mặt phẳng sao cho các đường epipolar của hai điểm phản chiếu

là song song theo chiều ngang và liên kết dọc theo mặt phẳng hình ảnh mới để

có thể so sánh giữa hai cặp hình ảnh minh họa Hình 3.16.

Đây là quá trình đi tìm phép biến đổi H của hai ma trận: Ma trận tổng quát E

(Essential) hoàn toàn về hình học cơ sở mang tính chất thông tin về vật lý; ma

trận căn bản F (Fundamental) liên quan các điểm ảnh trên mặt phẳng ảnh tính

theo tọa độ các điểm ảnh.

+ Tính toán ma trận tổng quát E (Essential matrix): xác định mối quan hệ

81

e’ e’

e

z e

y

x

0

a) Moâ hình camera chuyeån ñoäng b) Tìm caùc ñöôøng epipolar treân hai quan saùt

Hình 3.15 Kết quả tìm đường eplipolar trên mô hình camera chuyển động

P

b

PF

PT bc

bc

eT

bc

eF

bc

⊕ OT OF ⊕

Hình 3.16 Minh họa hiệu chỉnh hình ảnh trên cùng mặt phẳng ngang

82

giữa điểm P và hai điểm PF và PT từ phép chiếu lên hai mặt phẳng ảnh

F và T bởi công thức sau:

Q Q

PF = R(PT − T ) (3.15)

Trong đó mặt phẳng ảnh F chứa các vector PT và T , do đó nếu chọn một

vector (PT × T ) vuông gócQ với cả hai thì một phương trình cho tất cả các

điểm PT đi qua T và chứa cả hai vector được xác đinh như sau:

T

(PT − T ) (T × PT )=0 (3.16)

Thay (PT − T )= R−1PF và RT = R−1 vào công thức (3.16) ta có

T T

(R PF ) (T × PT )=0 (3.17)

Khi thực hiện phép nhân ma trận thì luôn tồn tại một đường chéo của ma

trận kết quả S nhận giá trị 0:

0 −Tz Ty

T × PT = SPT ⇒ S = Tz 0 −Tx (3.18)

−T T 0

y x

Các công thức trên được viết lại như sau:

T

PF EPT =0 (3.19)

Khi đó E = RS định nghĩa là mà trận tổng quát.

+ Tính toán ma trận cơ bản F (Fundamental matrix): Gọi MT và MF là tham

số trong của camera OT và OF , PT và PF là tọa độ của PT và PF .

PT = MT PT

(3.20)

PF = MF PF

Áp dụng công thức (3.19) để triển khai với ma trận F, ta có:

T

PF F PT =0 (3.21)

−1 T −1 −1 T −1

Khi đó F =(MF ) EMT =(MF ) RSMT là định nghĩa ma trận cơ bản.

Chúng tôi áp dụng kỹ thuật của Pollefeys [110] để hiệu chỉnh hai ảnh thu nhận

từ hai quan sát trước và sau khi camera chuyển động.

Hình 3.17(a) minh họa phương pháp chuyển đổi hình ảnh từ tọa độ đề các thông thường

83

Quan saùt tröôùc Quan saùt sau r

8 9 1

2 aaaaa aaaaa

7 10 aaaaa aaaaa

aaaaa aaaaa

3 aaaaa aaaaa

4

5

r

6 1 6

1

2 7

3

aaaaaaaa

aaaaaaaa

aaaaaaaa 4 8

aaaaaaaa

aaaaaaaa

aaaaaaaa

aaaaaaaa 9

aaaaaaaa

5 2

10

4 3 1

1 2 3 4 1 2 3 4

(a). Toïa ñoä cöïc treân aûnh (b). AÛnh ñaõ chuyeån ñoåi 2 quan saùt

(löôïng töû hoùa: 4 möùc theo r, 10 möùc theoj ) sang toïa ñoä cöïc

Hình 3.17 Kết quả hiệu chỉnh hình ảnh

về tọa độ cầu sao cho hai điểm epiolar e và e′ trùng nhau. Hình 3.17(b) xoay hai hình

ảnh về tọa độ cực sao cho các đường epiolar song song với nhau.

3.5.2.3 Đối sánh hình ảnh

Mục đích là tính toán giá trị chênh lệch của một điểm vật lý trên hai ảnh IT và

IF . Chúng tôi sử dụng phương pháp tổng sự khác biệt tuyệt đối SAD [70] [42]:

SAD(x,y,d)= |IT (x, y) − IF (x, y − d)| (3.22)

x,y∈W

X

Trong đó: IT và IF là hai ảnh đưa vào tính toán; (x, y) tọa độ điểm ảnh; W là cửa sổ

quét có kích thước (3 × 3), (5 × 5), (7 × 7); phạm vi chênh lệch d< 120.

Kết quả của hàm SAD cho biết tổng sự khác biệt của các khối dữ liệu dò tìm trên

ảnh thứ hai khi đưa vào tính toán Hình 3.19 mô tả quá trình tính toán trượt cửa sổ để

tìm ra khối dữ liệu phù hợp, giá trị lớn nhất trong biểu đồ quyết định vị trí đối sánh

chính xác.

84

(x ,y)

(x ,y)

u u’

Hình 3.18 Dò tìm khối dữ liệu trên hai ảnh được hiệu chỉnh

¡ ¢

ui’

Hình 3.19 Kết quả đối sánh ảnh sử dụng giải thuật SAD

85

3.5.2.4 Tính toán độ sâu

Mục đích của việc này là tìm ra độ sâu của các điểm ảnh trên bản đồ chênh lệch

(Disparity map) dựa vào phép đổi hình học để tính toán khoảng cách giữa các điểm

ảnh tương ứng trên đường epipoline. Theo [110] [142] các tham số được định nghĩa như

sau:

− Gọi e và e′ là hai mặt phẳng điểm ảnh của hai quan sát đưa vào.

− d là độ sâu của điểm ảnh, f tiêu cự của ống kính.

− a và b là khoảng cách điểm epipolar so với mặt phẳng chiếu e và e′, Z và B

khoảng cách giữa hai ống kính.

− X là độ chênh khoảng cách giữa hai điểm epiolar.

f

bc d d bc

bc e’ bc

b

f

d bc bc d d

bc bc

a

bc bc

X b

bc

e bc

b

bc bc

bc Z B

(a) Dự đoán khoảng cách từ hai quan sát (b) Tính toán độ sâu ảnh trong không gian 3D

Hình 3.20 Minh họa phương pháp tính bản độ chênh lệch

Hình 3.20(a) mô tả việc dự đoán khoảng cách từ quan sát e tịnh tiến đến quan

sát e′. Các điểm nằm trên đường epipole sẽ dự đoán chính xác khoảng cách d trong tọa

độ thế giới thực. Hình 3.20(b) mô tả chi tiết cách tính toán khoảng cách từ hai quan

sát đến vật thể, xuất phát từ cặp tam giác đồng dạng tính như sau:

b Z ZX

= ⇒ b = (3.23)

X Z + B − f X + B − f

a f fb

= ⇒ a = (3.24)

b B − f B − f

86

Thay b từ công thức (3.23) vào biểu thức a trong công thức (3.24) ta có:

fXZ

a = (3.25)

(Z + B − f)(B − f)

Và cuối cùng trong tập tam giác tương tự, khoảng cách độ sâu d được tính như sau:

d + a f fX

= ⇒ d = − a (3.26)

Z Z x

fX fZX f(Z + B − f)(B − f) − fZ2

d = − ⇒ d = X (3.27)

Z (Z + B − f)(B − f) Z(Z + B − f)(B − f)

Sau khi tính được độ sâu d của các điểm ảnh trên bản đồ chênh lệch, thay giá trị

này vào công thức (3.13) để xác định khoảng cách vật lý của các điểm ảnh. Kết quả

khoảng cách dự đoán trên vùng phát hiện là trung bình khoảng cách các điểm ảnh

nằm trong vùng xác định, minh họa hình dưới đây.

(a). Phaùt hieän vaät caûn coá ñònh (KetPoint Matching)

(b). Phaùt hieän ngöôøi (HoG-SVM)

Hình 3.21 Kết quả phát hiện & ước lượng khoảng cách vật cản trên ảnh độ sâu

87

3.6 Kết quả đánh giá

3.6.1 Xây dựng cơ sở dữ liệu vật cản

Từ kết quả đánh giá hiệu năng nhận dạng trên các lớp đối tượng thuộc CSDL

lớn trong và ngoài nước như: Naiscorp 2012, PascalVoc2007 và RobotVision2013 (PHỤ

LỤC C). Đồng thời tiến hành khảo sát tại 03 môi trường (Trường THCS Nguyễn Đình

Chiểu; Thư viện Tạ Quang Bửu, Viện nghiên cứu quốc tế MICA - Trường Đại học

Bách khoa Hà Nội), chúng tôi xây dựng CSDL vật cản bao gồm 04 đối tượng:

− Vật cản tĩnh: 00. Chậu hoa, 01. Bình cứu hỏa, 02. Thùng rác.

− Vật cản động: 03. Người.

- Thu thập cơ sở dữ liệu: Chúng tôi tiến hành thu thập đồng thời 02 luồng

dữ liệu hình ảnh vào 3 thời điểm khác nhau (sáng, trưa, tối): (i) luồng dữ liệu khung

cảnh phục vụ đánh giá phát hiện đối tượng, (ii) luồng dữ liệu đường đi phục vụ việc

đánh giá ước lượng khoảng cách. Bảng 3.1 trình bày kết quả thu nhận dữ liệu đánh

giá. Trong mỗi lần thực hiện thu dữ liệu 3 lần tương ứng với tốc độ di chuyển của

robot (Hình 3.22).

Bảng 3.1 Kết quả thu nhận dữ liệu khung cảnh/đường đi phục vụ đánh giá

❵❵❵

❵❵❵

❵❵❵ Vận tốc Số khung hình (frames)

❵❵❵

Thời gian ❵❵❵❵ v = 100mm/s v = 200mm/s v = 300mm/s

Sáng (L1) 481 256 175

Trưa (L2) 426 243 164

Chiều tối (L3) 431 251 170

Tổng số 1338 750 509

(a) Hình aûnh khung caûnh (b) Hình aûnh ñöôøng ñi

Hình 3.22 Minh họa hình ảnh thu nhận dữ liệu tại khung hình 289

88

- Chuẩn bị dữ liệu đánh giá hiệu năng của giải thuật phát hiện đối

tượng: Trên luồng dữ liệu khung cảnh, chúng tôi khoanh vùng các vật cản đã định

nghĩa ở trên và lưu vào CSDL biểu diễn môi trường. Quá trình này được thực hiện

bằng tay như minh họa trong Hình 3.23.

(x=341; y=143)

(x=206; y=226)

(x=557; y=333)

(x =310; y =351)

£ £

(x =609; y =448)

£ £

(x =423; y =330)

£ £

(a) Khoanh vuøng ñoái töôïng (b) Toïa ñoä caùc ñoái töôïng

Hình 3.23 Minh họa chuẩn bị dữ liệu đánh giá phát hiện đối tượng

- Chuẩn bị dữ liệu đánh giá độ chính xác của giải thuật ước lượng

khoảng cách:. Trên luồng dữ liệu đường đi, chúng tôi tiến hành đo và đánh dấu

khoảng cách vị trí vật cản có trong môi trường. Khoảng cách của đối tượng so với gốc

tọa độ được xác định như minh họa trong Hình 3.24.

y(m) y(m)

31.04

03: Thuøng raùc

y(m)

17.67

04: Ngöôøi

Thu thaäp döõ lieäu

9,85

Robot

7.40

01: Bình cöùu hoûa

5,96 Döõ lieäu maët ñöôøng DöFile đính kèm:

luan_an_nghien_cuu_va_phat_trien_mot_so_ky_thuat_dinh_vi_dua.pdf

luan_an_nghien_cuu_va_phat_trien_mot_so_ky_thuat_dinh_vi_dua.pdf